Come probabilmente saprai, c’è una domanda insaziabile di intelligenza artificiale e dei chip su cui questa deve girare. Tanto che Nvidia è ora la sesta azienda al mondo per capitalizzazione di mercato, con 1,73 trilioni di dollari al momento in cui scriviamo. Il fenomeno non mostra segni di rallentamento: persino Nvidia sta lottando per soddisfare la domanda in questo nuovo e coraggioso mondo dell’intelligenza artificiale. La stampante di denaro fa brrrr.

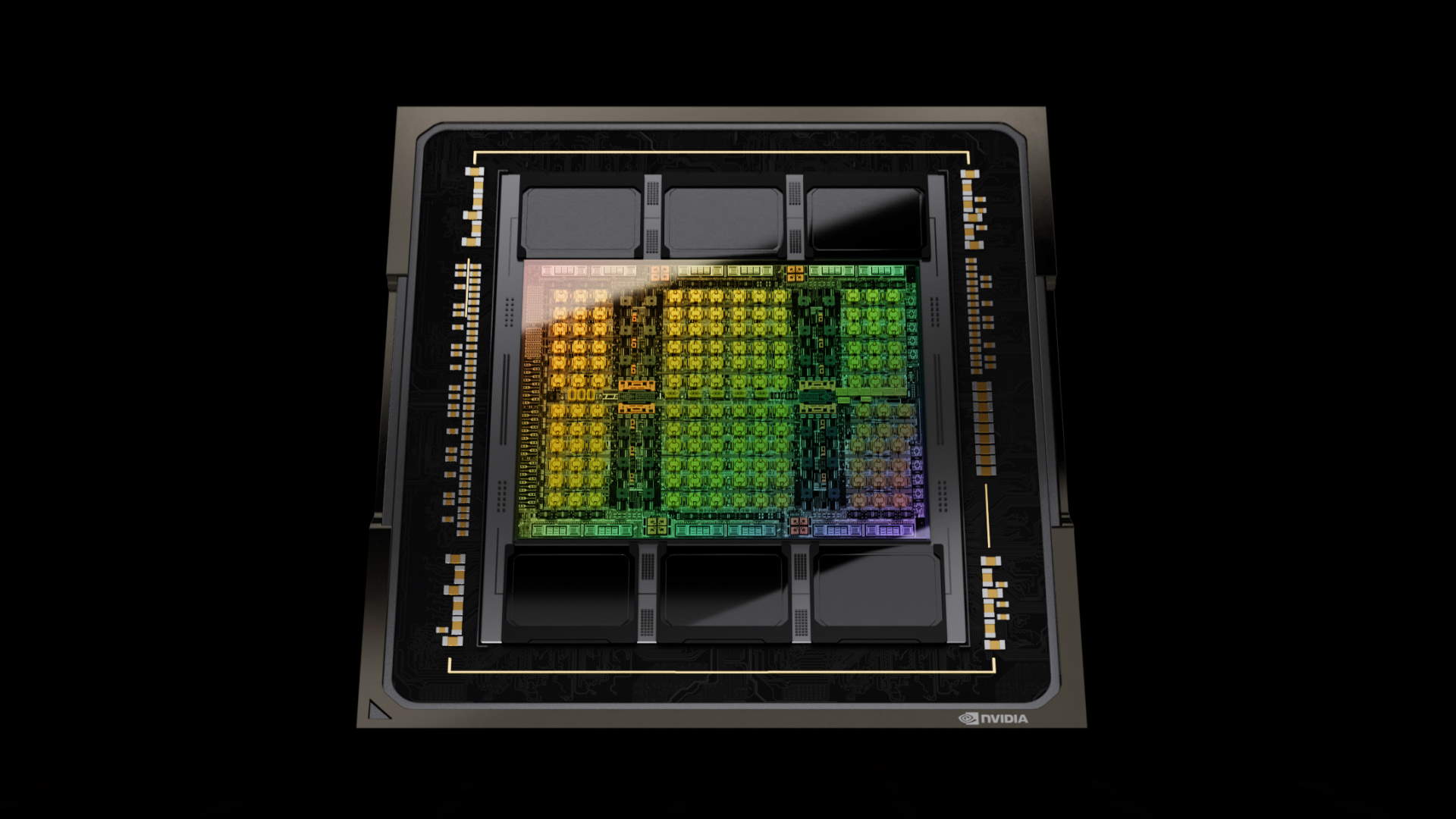

Per semplificare la progettazione dei suoi chip AI e migliorare la produttività, Nvidia ha sviluppato un Large Language Model (LLM) che chiama ChipNeMo. Il modello raccoglie essenzialmente i dati delle informazioni architettoniche, dei documenti e del codice interni di Nvidia, per comprendere la maggior parte dei suoi processi interni. Si tratta di un adattamento del Llama 2 LLM di Meta.

È stato presentato per la prima volta nell’ottobre del 2023 e, secondo il Wall Street Journal (via Business Insider), il feedback è stato finora promettente. Secondo quanto riportato, il sistema si è rivelato utile per la formazione dei giovani ingegneri, consentendo loro di accedere a dati, note e informazioni tramite il chatbot.

Grazie alla presenza di un chatbot AI interno, i dati possono essere analizzati rapidamente, con un notevole risparmio di tempo e senza dover ricorrere a metodi tradizionali come l’e-mail o la messaggistica istantanea per accedere a determinati dati e informazioni. Considerando il tempo che può essere necessario per rispondere a un’e-mail, per non parlare del tempo che si impiega in strutture e fusi orari diversi, questo metodo offre sicuramente un gradito impulso alla produttività.

Nvidia è costretta a lottare per accedere ai migliori nodi di semiconduttori. Non è l’unica ad aprire i libretti degli assegni per accedere ai nodi all’avanguardia di TSMC. Mentre la domanda aumenta, Nvidia fatica a produrre un numero sufficiente di chip. Quindi, perché comprarne due quando si può fare lo stesso lavoro con uno solo? Questo spiega perché Nvidia sta cercando di accelerare i propri processi interni. Ogni minuto risparmiato si aggiunge ad altri, aiutando l’azienda a portare sul mercato prodotti più veloci in tempi più brevi.

Cose come la progettazione di semiconduttori e lo sviluppo di codici sono ideali per i LLM di intelligenza artificiale. Sono in grado di analizzare i dati in modo rapido e di eseguire compiti che richiedono molto tempo, come il debug e le simulazioni.

Prima ho citato Meta. Secondo Mark Zuckerberg (via The Verge), Meta potrebbe avere una scorta di 600.000 GPU entro la fine del 2024. Si tratta di un sacco di silicio e Meta è solo un’azienda. Se a questo si aggiungono aziende del calibro di Google, Microsoft e Amazon, è facile capire perché Nvidia voglia portare i suoi prodotti sul mercato prima. Ci sono montagne di soldi da guadagnare.

A parte le grandi tecnologie, siamo ancora lontani dal comprendere appieno gli usi dell’intelligenza artificiale basata sui bordi nei nostri sistemi domestici. Si può immaginare che l’intelligenza artificiale che progetta hardware e software migliori diventerà sempre più importante e diffusa. Questo fa un po’ paura.

Leggi di più su www.pcgamer.com

Absolutegamer è un gruppo di nerd vecchia scuola, progressisti, appassionati di gaming, meglio se indie, saltuariamente retro ma senza essere snob verso l’ultima versione di Unreal Engine, con un atteggiamento no bullshit e con una certa predisposizione all’attivismo. Hanno generalmente un umorismo discutibile ma se volevano piacere a tutti nascevano patate fritte.

They/Them (ovviamente, geni)